Unkrauterkennung und Kartierung zur automatischen Applikationskartenerstellung im Pflanzenschutz

Weed detection and mapping for automatic application map generation in crop protection

Journal für Kulturpflanzen, 73 (5-6). S. 121–130, 2021, ISSN 1867-0911, DOI: 10.5073/JfK.2021.05-06.04, Verlag Eugen Ulmer KG, Stuttgart

| Dies ist ein Open-Access-Artikel, der unter den Bedingungen der Creative Commons Namensnennung 4.0 International Lizenz (CC BY 4.0) zur Verfügung gestellt wird (https://creativecommons.org/licenses/by/4.0/deed.de). This is an Open Access article distributed under the terms of the Creative Commons Attribution 4.0 International License (https://creativecommons.org/licenses/by/4.0/deed.en). |

Für eine künftig umweltverträgliche und teilflächenspezifische Anwendung von Herbiziden ist eine genaue Kenntnis über die Zusammensetzung und die räumliche Verteilung von Nutzpflanzen und Unkräutern auf Ackerflächen erforderlich. Sind diese Informationen bekannt, können sie in Unkrautverteilungskarten abgebildet werden und dienen dann als Basis für die Erstellung von Applikationskarten. Eine bislang fehlende Prozesskette beginnend beim Pflanzenmonitoring auf dem Acker, über Methoden zur automatischen Identifizierung von Einzelpflanzen und der Generierung von Verteilungskarten wurden erstmals durchlaufen. Hierzu wurden im Projekt „Assistenzsystem zur teilflächenspezifischen Applikation von Pflanzenschutzmitteln (AssSys)“ manuelle Kamera-gestützte Feld- und Halbfreilandbonituren typischer Verunkrautungssituationen und Feldbefliegungen mit einem Multicopter genutzt, um die Position und die Bestandsdichten von Unkräutern und Kulturpflanzen zu bestimmen und zu kartieren. Die Segmentierung aller Aufnahmen erfolgte manuell mit einer eigenständig entwickelten Software zur Annotation von Bilddaten und nach dem Training von umfangreichen Datensätzen automatisch mit Methoden des maschinellen (Bag-of-visual Words) und tiefen Lernens (Convolutional Neural Networks). Es zeigte sich, dass die getesteten Algorithmen für eine Vorhersage von ein- und zweikeimblättrigen Pflanzenarten geeignet sind. Die aus den Feldbonituren gewonnenen Daten wurden in Applikationskarten überführt und von den Partnern des Projektes genutzt, um in praxisnahen Feldversuchen teilflächenspezifische, selektive Unkrautbekämpfungsmaßnahmen mit einem Direkteinspeisungssystem durchzuführen.

Stichwörter: Unkrauterkennung, Unkrautverteilungskarten, teilflächenspezifischer Pflanzenschutz, maschinelles Lernen, künstliche Intelligenz, Bildverarbeitung

For environmental and site-specific application of herbicides in the coming future, precise knowledge of the structure and spatial distribution of crops and weeds on arable land is required. If this information is known, it can be mapped in weed distribution maps and then serve as a basis for the generation of application maps. A process chain that has been missing so far, starting with plant monitoring in the field, through methods for the automatic identification of individual plants and the generation of distribution maps, was run through for the first time in a first approach as part of the work package “Weed Identification and Mapping”. For this purpose, the AssSys project used manual camera-based field and semi-field sampling of typical weed situations and automatic field aerial photographs with a multicopter to determine and map the position and population densities of weeds and crop plants. All images were segmented manually using an own developed software for annotation of image data and after training of large datasets comparatively using methods of machine learning (Bag-of-visual Words) and deep learning (Convolutional Neural Networks). It was shown that the tested algorithms are suitable for predicting mono- and dicotyledonous plant species. The data obtained from the field sampling were converted into application maps and used by the project partners as part of their work packages to carry out site-specific, selective weed control treatments with a direct-injection system in practical field trials.

Key words: Weed detection, weed distribution maps, site-specific crop protection, machine learning, artificial intelligence, image processing

Unkräuter zählen nach wie vor zu den wichtigsten Schadorganismen im Ackerbau, was im Wesentlichen auf eine starke Konkurrenzwirkung bezüglich Licht-, Wasser- und Nährstoffaufnahme zurückzuführen ist (Milberg & Hallgren, 2004). Unkräuter sind auf Anbauflächen in der Regel nicht homogen verteilt, sondern vielmehr in Clustern oder Nestern, wodurch die Basis für ein teilflächenspezifisches Unkrautmanagement geschaffen wird. Hierbei kann die Applikation von Herbiziden hinsichtlich Aufwandmenge und Herbizidwahl an die räumlich variablen Unkrautsituationen landwirtschaftlicher Flächen angepasst und damit eine Reduzierung der Pflanzenschutzintensität ermöglicht werden. Voraussetzung für ein teilflächenspezifisches Unkrautmanagement ist eine exakte Erfassung der Unkrautdichte und -arten mit möglichst hoher räumlicher Auflösung (Häusler & Nordmeyer, 1999; Christensen et al., 2003; Nordmeyer, 2006; López-Granados, 2011). Derzeit werden im Wesentlichen stichprobenartige Feldbegehungen begleitet von manuellen Unkrautbonituren durchgeführt. Eine umfassende Unkrauterfassung über die gesamte Ackerfläche ist hierbei meist nicht realisierbar. Eine höher aufgelöste Datengewinnung zur Unkrautverteilung könnte dagegen mit Hilfe optischer Sensoren im Online-Verfahren (mit Kameras an Schlepper oder Feldspritzgerät) bzw. durch Bildaufnahmen autonom fliegender Sensorplattformen (UAV) im sogenannten Offline-Verfahren erreicht werden. Im Ergebnis beider Verfahren werden schlagspezifische Unkrautverteilungskarten generiert, die die Grundlage für Applikationskarten bilden und somit eine zielgenaue Applikation von Herbiziden ermöglichen.

Verfahren zur Vegetationsfernerkundung werden in der Landwirtschaft bereits seit mehreren Jahrzehnten genutzt. In der Regel werden Satellitenbilder oder Aufnahmen aus bemannten Befliegungen analysiert, um die räumliche Variabilität einer landwirtschaftlichen Kulturfläche zu identifizieren und Kulturmaßnahmen (z. B. Düngung) teilflächenspezifisch anzupassen (Dobers, 2002; Kluge & Nordmeyer, 2012). Die zeitliche Verfügbarkeit von Satellitenbildern ist jedoch begrenzt und bietet nur eine sehr grobe Auflösung. Alternativ ermöglicht der technische Fortschritt auf den Gebieten der Robotik und Informatik neue Möglichkeiten, die die Entwicklung von autonomen Flugsystemen und leistungsfähigen Bildverarbeitungsalgorithmen auch für die Landwirtschaft erschwinglich machen. Gleichzeitig wurde die Hardware optischer Systeme signifikant weiterentwickelt, was neben der sicheren Navigation von UAVs in geringer Flughöhe (5 m) die Voraussetzung für eine hohe photogrammetrische Abbildungsleistung schafft und letztendlich die artspezifische Erfassung von Einzelpflanzen auf einer Kulturfläche potentiell ermöglicht (Pflanz & Nordmeyer, 2016).

Für die Unkrauterkennung selbst werden zunehmend Methoden des maschinellen Lernens adaptiert, die durch eine objektbasierte Klassifikation eindeutiger Merkmale bei der automatischen Bestimmung vieler Unkrautarten bereits erste Fortschritte erzielen konnten (Pflanz et al., 2018b). Diese Ansätze in der Bildanalyse berücksichtigen lokale, invariante Formenmerkmale in hochauflösenden Bildaufnahmen, um Unkräuter, Kulturpflanzen und Boden voneinander zu unterscheiden (Dyrmann et al., 2016)

Für die Überführung von wissenschaftlich erprobten Verfahren wurden im Rahmen des Projektes „AssSys“ Möglichkeiten der automatisierten Unkrauterkennung evaluiert. Ziel war es, möglichst exakte Unkrautverteilungskarten zu generieren und als Applikationskarten in das entwickelte Assistenzsystem zu integrieren. In Feldversuchen wurde das System im Hinblick auf den Erfolg der differenzierten Unkrautbekämpfung validiert. In diesem Beitrag sollen insbesondere Ergebnisse der Forschungs- und Entwicklungsarbeiten im Bereich der optischen Unkrauterfassung dargestellt werden.

Die Durchführung der Feldversuche erfolgte in den Jahren 2017–2019 auf 4–7 ha großen Versuchsflächen des Julius Kühn-Instituts und externer Landwirte in Niedersachsen und Sachsen-Anhalt. Es wurden Ackerflächen in verschiedenen Regionen mit unterschiedlichen klimatischen Bedingungen und Bodenverhältnissen ausgewählt. Die Versuche wurden ausschließlich in Getreide (Winter- und Sommerweizen, Wintergerste) durchgeführt (Wellhausen et al., 2019).

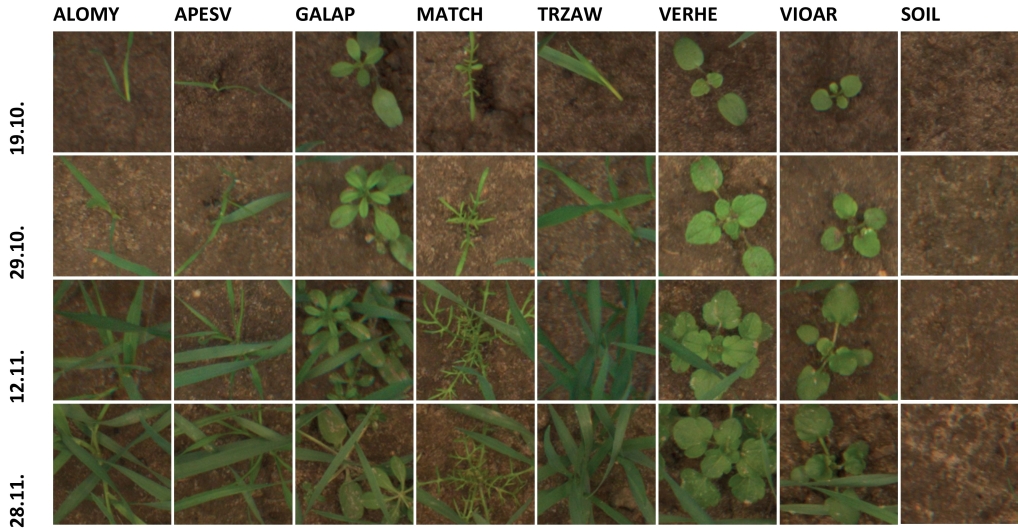

Zusätzlich zu den Feldversuchen wurden außerdem Halbfreilandversuche in sog. Betonparzellen zur Erstellung von Bildaufnahmen unter kontrollierten Bedingungen durchgeführt. Dazu wurden einkeim- und zweikeimblättrige Unkräuter im Entwicklungsstadium BBCH 12 in unterschiedlichen Kombinationen und Dichten in einen zuvor ausgesäten Weizenbestand pikiert. Im Anschluss erfolgte die Bildaufnahme in einem eigens dafür konzipierten Gestell, welches Aufnahmen in einer konstanten Höhe und unter gleichbleibenden Lichtbedingungen ermöglichte (Pflanz et al., 2018a). Die Bildaufnahmen wurden in regelmäßigen Abständen zwei Mal wöchentlich durchgeführt, um die Entwicklung der Kulturpflanzen und Unkräuter abzubilden (Abb. 1).

Abb. 1. Beispiele der regelmäßigen Bildaufnahmen einkeim- und zweikeimblättriger Unkrautpflanzen und Weizen des Halbfreilandversuchs (dargestellt sind 4 von insgesamt 12 Aufnahmeterminen). Zusätzlich dargestellt sind Aufnahmen der Kategorie Boden (SOIL), die im Aufnahmezeitraum keine signifikanten Veränderungen der oberflächlichen Bodenstruktur zeigten. ALOMY, Alopecurus myosuroides; APESV, Apera spica-venti; GALAP, Galium aparine; MATCH, Matricaria recutita; TRZAW, Triticum aestivum; VERHE, Veronica hederifolia; VIAOR; Viola arvensis

Mit Hilfe eines modifizierten Göttinger Zähl- und Schätzrahmens wurden auf jeweils 0,1 m2 großen Flächensegmenten und in einem Raster von 12 × 12 bzw. 24 × 24 m die vorhandenen Unkräuter vor dem Beginn der Herbizidapplikation auf den Versuchsflächen des JKIs und beteiligter Partner bonitiert. Hierzu wurden an jedem Boniturpunkt georeferenzierte Bildaufnahmen mit einer RGB-Kompaktkamera (Alpha 6000, Sony) erstellt, die in einer fixierten Höhe von 45 cm am modifizierten Zählrahmen befestigt war (Abb. 2). Die Brennweite der Kamera war ebenfalls fest eingestellt, sodass die Bildaufnahmen einen vergleichbar großen Flächenausschnitt aller Boniturpunkte zeigten. Die Belichtungszeit der Bilder wurde bei vorgegebener Blendenöffnung durch die Kameraautomatik errechnet (Wellhausen et al., 2020). Die Boniturergebnisse wurden direkt über eine App in Echtzeit erfasst und automatisch mit einer GPS-Koordinate versehen. Somit standen die Boniturdaten sofort in digitaler Form über das AssSys – WebPortal zur Verfügung

Abb. 2. Modifizierter Göttinger Zähl- und Schätzrahmen mit fest montierter Kamera zur Bilderfassung und einem Tablet zur Erfassung der GPS-Koordinaten und Unkraut-Boniturdaten.

Die Klassifikation unterschiedlicher Arten durch die Vegetationserkundung wurde durch hochauflösende Luftbildaufnahmen und merkmalsextrahierende Bildverarbeitung erreicht. Es erfolgte eine Befliegung mit einem Multicopter (Oktopus, CiS GmbH), bei der mit einer RGB-Kompaktkamera (NEX 5N, Sony und Alpha 6000) Bilder an den Boniturpunkten in einer Flughöhe von 5 m erstellt wurden.

Aus den manuellen Bonituren wurden im Anschluss Unkrautverteilungskarten mittels der Software Surfer (Golden Software, LLC.) bzw. ArcMap (ArcGIS, esri Inc.) oder QGIS generiert. Diese schlagspezifischen, georeferenzierten Unkrautkarten dienten als Grundlage für die Erstellung von Applikationskarten für die Feldversuche zur Unkrautbekämpfung.

Auf Basis der jeweiligen Unkrautart und -dichte und den artspezifischen Schadschwellen wurden auf den Flächen Bereiche definiert, in denen eine Anwendung unterschiedlicher Herbizide mit einer Direkteinspeisungsspritze (Herbert Dammann GmbH) oder aber keine Anwendung von Herbiziden erfolgte. Die Wirksamkeit dieser durchgeführten teilflächenspezifischen Unkrautbekämpfungsmaßnahmen wurde anschließend kontrolliert und bonitiert. Hierzu wurde 4 bis 6 Wochen nach der Applikation ebenfalls durch manuelle Bonitur die Verunkrautung mit einem Göttinger Zahl- und Schätzrahmen erfasst (Pohl et al., 2020).

Die Klassifizierungsleistung von neuronalen Netzwerkstrukturen ist sehr stark von der Größe des Trainingsdatensatzes, also der Menge trainierter Bilder und der daraus extrahierten Objektmerkmale, abhängig. Während bei klassischen Methoden des maschinellen Lernens wie z. B. der Erkennung mit Hilfe des Bag-of-visual-Words-Ansatzes (BoVW), bereits mit wenigen tausend trainierten Bildern vergleichsweise hohe Erkennungsraten erreicht werden können, tritt ein robuster Lerneffekt bei den derzeit vielfach verwendeten Convolutional Neural Networks (CNNs) erst bei größeren Bilddatensätzen je Kategorie ein (Krizhevsky et al., 2017).

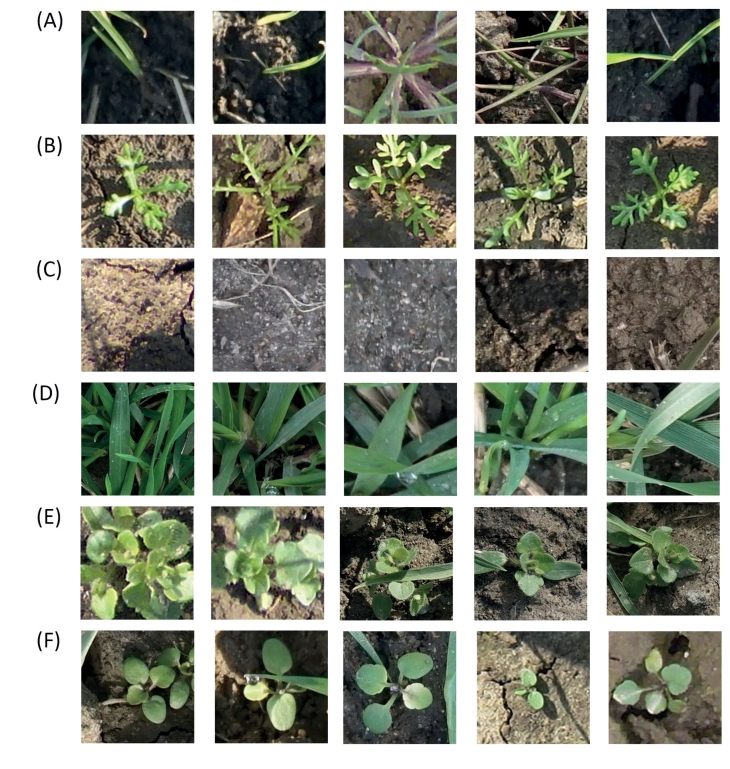

Aus diesem Grund wurden Bilder von typischen Unkrautsituationen auf den Versuchsfeldern aufgenommen und anschließend manuell am PC annotiert. In der hierfür am Institut für Pflanzenschutz in Ackerbau und Grünland des JKI entwickelten Software (ImageObjectLocator Version 0.38) können Einzelpflanzen artspezifisch durch gezielte Platzierung von Markierungen identifiziert und pixelbasiert verortet werden (Abb. 3). Auf Basis der Pflanzenposition erfolgte anschließend eine Segmentierung der Gesamtaufnahme in 200 × 200 Pixel große Bildausschnitte der einzelnen Unkrautpflanzen (Abb. 4). Die so erzeugten Bilddaten von vereinzelten Unkräutern bilden den Trainingsdatensatz und umfassten die Unkrautarten Alopecurus myosuroides (ALOMY), Matricaria spp. (MATSS), Veronica spp. (VERSS) und Viola arvensis (VIOAR) sowie Winterweizen (TRZAW) und die Hintergrundklasse Boden (SOIL).

Abb. 4. Annotierter Bilddatensatz (Auswahl) verschiedener Verunkrautungssituationen für die CNN-Klassifikation. Trainiert wurden die Klassen (A) ALOMY, (B) MATSS, (C) SOIL, (D) TRZAW, (E) VERSS und (F) VIOAR.

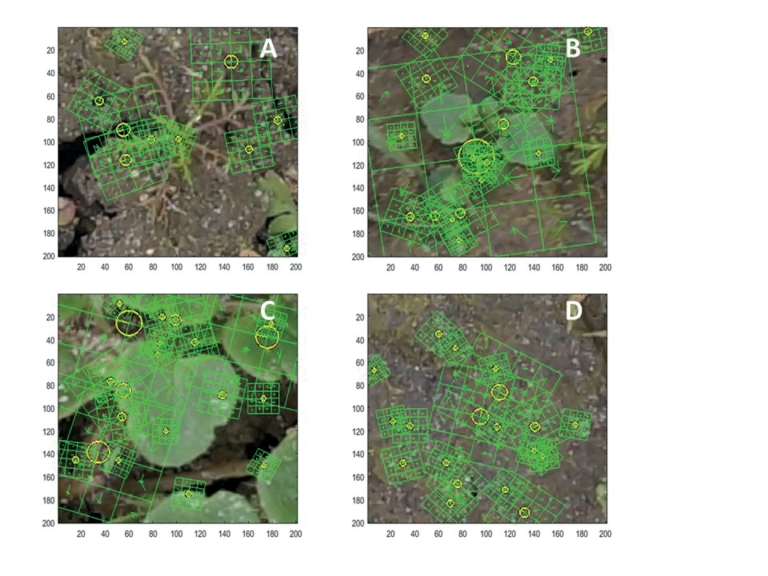

Eines der Ziele dieser Studie war es, die Eignung von deep-learning-Algorithmen unter Verwendung von CNNs den bisher verwendeten klassischen Ansätzen von maschinellem Lernen auf Basis des Bag-of-visual-Words (BoVW) gegenüberzustellen (Pflanz et al., 2018a). In Abb. 5 sind beispielhaft einige Bilder (samples) für bedeutende Unkrautarten und die häufig vorkommende Hintergrundklasse Boden (SOIL) dargestellt. Für die Detektion und Beschreibung lokaler Bildmerkmale mit Hilfe des BoVW-Ansatzes wurde zunächst ein Algorithmus verwendet, der eine skaleninvariante Merkmalstransformation ermöglicht (engl. Scale-invariant feature transform – SIFT). Dies ist erforderlich, da die Orientierung und Größe der gesuchten Unkrautpflanzen im Bild sehr unterschiedlich sein kann. SIFT-Deskriptoren sind weitestgehend invariant gegenüber Koordinatentransformationen wie Translation, Rotation und Skalierung. In begrenztem Umfang können durch SIFT-Transformationen auch Effekte wie Bildrauschen oder variierende Beleuchtungssituationen ausgeglichen werden. Signifikante Strukturen eines Bildes werden mit Längen- und Richtungsvektoren beschrieben, die in einer 4x4-Matrix gespeichert sind.

Abb. 5. Lage gefundener Keypoints (gelb) und ihrer SIFT-Deskriptoren (grün dargestellt als 4x4 Geometrie mit Orientierung). Zur besseren Anschauung wurden nur 10 zufällig ausgewählte SIFT-Deskriptoren pro Bildklasse eingezeichnet. A) MATCH, B) VIOAR C), VERHE D) SOIL.

Hier wird deutlich, dass je nach Pflanzenart und verwendetem Feature-Extraktor teils sehr viele beschreibende Attribute (features) in den Bildern gefunden werden. Dies ist für Feldaufnahmen relativ typisch. In der Folge müssen Netzwerkstrukturen trainiert werden, die auch bei einer sehr großen Anzahl an Merkmalen auf eindeutige Muster verallgemeinern können, was bei Vorhersagen mit dem Ansatz der Bag-of-Words in der Regel nur bei wenigen zu unterscheidenden Klassen zuverlässig ist.

Bei CNN-trainierten Modellen werden die verschiedenen Merkmalsextraktoren (hier als Filter bezeichnet) dagegen in verschiedenen Schichten, den Convolution Layer abgebildet, wodurch eindeutige Muster auch in einer großen Menge von Features erkannt werden können. Für die vorliegenden Bilddatensätze der Kategorien ALOMY, MATSS, VERSS, VIOAR und TRZAW, sowie für die Hintergrundkategorie SOIL wurden Standard-CNNs mit sechs Ebenen (Conv2D-Layer: 32, 32, 64, 128, 256, 16) in 15 Epochen mit einer BatchSize von 8 trainiert. Dies erfolgte mit Hilfe der deep learning-Bibliothek Keras (Version 2.2.4) und des Lernframeworks TensorFlow (Version 2.0) unter Python 3.7 (Chollet, 2015). Die Generierung der Modelle war auf einer Xeon E5-Workstation mit einer Quadro P4000-Grafikkarte nach etwa fünf Stunden abgeschlossen. Das CNN-Vorhersagemodell des Trainingsdatensatzes wurde auf einem unabhängigen Testdatensatz validiert.

Eine erste Validierung der BoVW-Modelle auf einem Testdatensatz von zufälligen Einzelbildern aus den Betonparzellen ergab eine Gesamtgenauigkeit von 82,2 % (Tab. 1). Für die zweikeimblättrigen Unkrautarten Galium aparine (GALAP), Matricaria recutita (MATCH), Veronica hederifolia (VERHE) und Viola arvensis (VIAOR) lag der Anteil an richtig vorhergesagten Ergebnissen bezogen auf die Gesamtheit aller als positiv vorhergesagten Ergebnisse (Precision) über 88 %. Die Trefferquote (Recall), also der Anteil korrekt als positiv klassifizierter Ergebnisse bezogen auf die Gesamtheit tatsächlich positiver Ergebnisse, lag in den gleichen Kategorien bei über 85 %. Bei den einkeimblättrigen Unkrautarten wurde eine Genauigkeit von 62 % (Alopecurus myosuroides, ALOMY) und 69 % (Apera spica-venti, APESV) erreicht, wohingegen die Trefferquote nur bei 42 bzw. 57 % lag. Auffällig sind die erzielten Ergebnisse für die Kategorie SOIL. Hier lag die Trefferquote der Vorhersage zwar bei 100 %, die Genauigkeit allerdings nur bei 78 %.

Tab. 1. Konfusionsmatrix der BoVW-Vorhersage für das Image TestSet. ALOMY, Alopecurus myosuroides; APESV, Apera spica-venti; GALAP, Galium aparine; MATCH, Matricaria recutita; SOIL, Hintergrund; TRZAW, Triticum aestivum; VERHE, Veronica hederifolia; VIAOR; Viola arvensis

| ALOMY | APESV | GALAP | MATCH | SOIL | TRZAW | VERHE | VIOAR | Recall |

ALOMY | 48 | 23 | 3 | 1 | 34 | 4 | 0 | 0 | 0,42 |

APESV | 24 | 62 | 0 | 3 | 9 | 9 | 0 | 1 | 0,57 |

GALAP | 1 | 1 | 61 | 3 | 0 | 2 | 2 | 2 | 0,85 |

MATCH | 1 | 1 | 0 | 59 | 6 | 0 | 0 | 0 | 0,88 |

SOIL | 0 | 0 | 0 | 0 | 184 | 0 | 0 | 0 | 1,00 |

TRZAW | 2 | 2 | 0 | 0 | 0 | 126 | 0 | 0 | 0,97 |

VERHE | 1 | 0 | 0 | 0 | 0 | 0 | 81 | 4 | 0,94 |

VIOAR | 0 | 1 | 5 | 0 | 2 | 0 | 2 | 66 | 0,87 |

Precision | 0,62 | 0,69 | 0,88 | 0,89 | 0,78 | 0,89 | 0,95 | 0,90 | 82,18 |

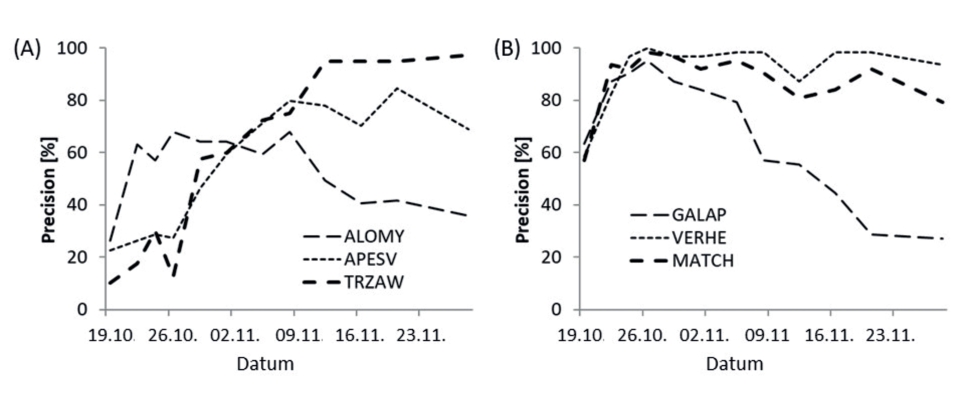

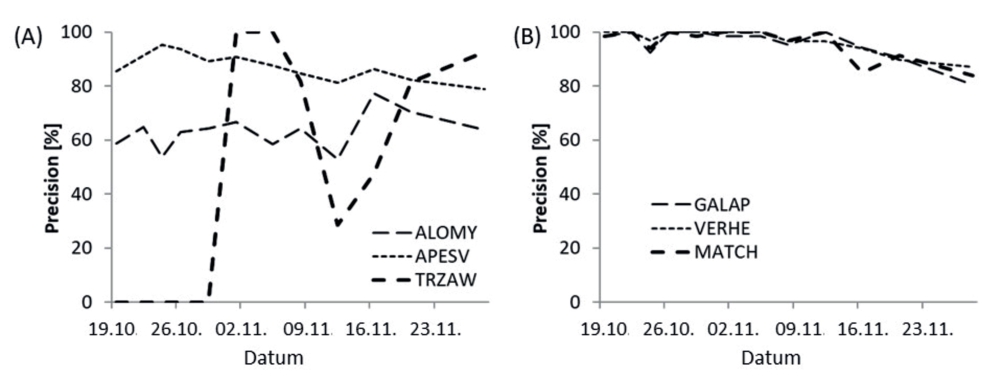

Darüber hinaus konnte festgestellt werden, dass die Vorhersagegenauigkeit der BoVW-Modelle eine Abhängigkeit vom Entwicklungsstadium der trainierten Unkräuter und des Weizens zeigt (Abb. 6). Die Vorhersagegenauigkeit nahm ab, wenn das Entwicklungsstadium der Pflanzen entweder zu klein oder zu groß war.

Abb. 6. Abhängigkeit der Vorhersagegenauigkeit sowie der Trefferquote der BoVW-trainierten Modelle vom Entwicklungsstadium von (A) einkeimblättrigen Unkräutern und Weizen sowie (B) zweikeimblättrigen Unkräutern. ALOMY, Alopecurus myosuroides; APESV, Apera spica-venti; TRZAW, Triticum aestivum; GALAP, Galium aparine; VERHE, Veronica hederifolia; MATCH, Matricaria recutita

Demgegenüber zeigt die Validierung der CNN-trainierten Modelle auf dem identischen Bilddatensatz eine Gesamtgenauigkeit von 95,10 % und liegt damit um etwa 13 % über dem Ergebnis der BoVW-Klassifizierung. Während mit den extrahierten signifikanten Merkmalen der zweikeimblättrigen Unkrautarten mit beiden Lernverfahren Klassifizierungsgenauigkeiten von mehr als 88 % erreicht werden konnten, war Erkennungsgenauigkeit des verwendeten CNN-Modells bei einkeimblättrigen Unkrautarten sehr viel größer als die der BoVW-Modelle. So konnten mit dem CNN-Modell auch einkeimblättrige Unkrautarten wie ALOMY und APESV mit einer Genauigkeit von mehr als 84 % und mit einer Trefferquote von mehr als 86 % bestimmt werden. Die Trefferquote für die Kategorie SOIL lag unverändert bei 100 %, während für die Genauigkeit im Vergleich zur Validierung der BoVW-Modelle hier Werte von 98 % erreicht wurden (Tab. 2). Zwar wurden keine vergleichenden Berechnungen ohne die Kategorie SOIL durchgeführt, es sollte aber dennoch davon auszugehen sein, dass das Trainieren von Merkmalen des Bildhintergrundes dazu beigetragen hat, die Gesamterkennungsleistung beider Lernverfahren zu erhöhen.

Tab. 2. Konfusionsmatrix der CNN-Vorhersage für das Image TestSet. ALOMY, Alopecurus myosuroides; APESV, Apera spica-venti; GALAP, Galium aparine; MATCH, Matricaria recutita; SOIL, Hintergrund; TRZAW, Triticum aestivum; VERHE, Veronica hederifolia; VIAOR; Viola arvensis

| ALOMY | APESV | GALAP | MATCH | SOIL | TRZAW | VERHE | VIOAR | Recall |

ALOMY | 98 | 10 | 0 | 0 | 3 | 2 | 0 | 0 | 0,87 |

APESV | 13 | 93 | 0 | 0 | 1 | 1 | 0 | 0 | 0,86 |

GALAP | 0 | 0 | 71 | 1 | 0 | 0 | 0 | 0 | 0,99 |

MATCH | 2 | 0 | 0 | 65 | 0 | 0 | 0 | 0 | 0,97 |

SOIL | 0 | 0 | 0 | 0 | 184 | 0 | 0 | 0 | 1,00 |

TRZAW | 2 | 0 | 0 | 0 | 0 | 128 | 0 | 0 | 0,98 |

VERHE | 1 | 0 | 1 | 0 | 0 | 0 | 83 | 1 | 0,97 |

VIOAR | 0 | 0 | 1 | 0 | 0 | 0 | 2 | 73 | 0,96 |

Precision | 0,84 | 0,90 | 0,97 | 0,98 | 0,98 | 0,98 | 0,98 | 0,99 | 95,10 |

Wie bei der Vorhersage mit BoVW-Modellen ergab sich auch bei der Erkennung von Unkrautarten mit CNN-Modellen eine Abhängigkeit vom Entwicklungsstadium der Pflanzen (Abb. 6). Diese Abhängigkeit ist bei der Vorhersage durch das trainierte CNN und insbesondere bei den zweikeimblättrigen Unkrautarten wesentlich geringer als bei der Verwendung der BoVW-Modelle. Für die einkeimblättrigen Unkrautarten ALOMY und APESV lag die Erkennungsgenauigkeit bei etwa 60 % bzw. 80 % und veränderte sich im beobachteten Entwicklungszeitraum nur unwesentlich (Abb. 7). Die ebenfalls einkeimblättrigen Weizenpflanzen waren jedoch besonders zu Beginn der Messungen nicht von ALOMY und APESV zu unterscheiden. Erst nach zwei Wochen konnten Weizenpflanzen korrekt identifiziert werden. Bei der Erkennung der zweikeimblättrigen Arten GALAP, VERHE und MATCH lag die Erkennungsgenauigkeit gleich zu Beginn der Messungen bei mehr als 98 % und sank auch bis zum Ende der vierwöchigen Versuchsreihe nicht auf Werte unter 80 % ab.

Abb. 7. Abhängigkeit der Vorhersagegenauigkeit sowie der Trefferquote CNN-trainierter Modelle vom Entwicklungsstadium von (A) einkeimblättrigen Unkräutern und Weizen sowie (B) zweikeimblättrigen Unkräutern. ALOMY, Alopecurus myosuroides; APESV, Apera spica-venti; TRZAW, Triticum aestivum; GALAP, Galium aparine; VERHE, Veronica hederifolia; MATCH, Matricaria recutita

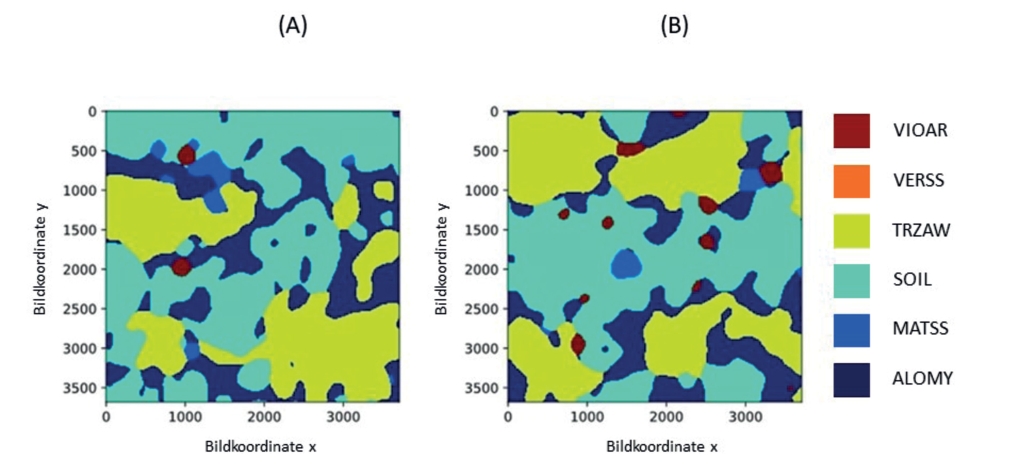

Im Rahmen des Projektes AssSys wurden die Unkrautverteilungskarten und die darauf aufbauenden Applikationsdaten auf Basis der manuellen Boniturdaten erstellt (Wellhausen et al., 2019, 2020). Da die manuelle Bonitur von ausreichenden Boniturpunkten aber sehr arbeits- und kostenintensiv ist, sollten hier zukünftig automatische Verfahren z. B. via UAV-Befliegung und automatischer Unkrauterkennung genutzt werden, um die Unkrautverteilung mit ausreichender Präzision zu erfassen. Für die Erprobung eines automatisierten Verfahrens zur Unkrauterkennung wurden die während der manuellen Bonitur aus geringer Höhe erstellten Bildaufnahmen genutzt. Die zuvor trainierten deep learning-Algorithmen wurden auf diese Bildaufnahmen angewendet und basierend auf dieser automatischen Unkrauterkennung Vorhersagekarten erstellt. Die in Abb. 8 dargestellten Vorhersagekarten für zwei der Versuchsflächen zeigen, dass sich die getesteten Algorithmen grundsätzlich für eine Vorhersage der richtigen Pflanzenart- bzw. Bodenkategorie eignen. Die Flächenanteile für MATSS und VIOAR wurden richtig geschätzt, jedoch wurde bei einem geringen Anteil ALOMY der Anteil durch die Modelle deutlich überschätzt. Dies tritt besonders bei der Betrachtung der Feldrandbereiche auf.

Abb. 8. Unkrautklassifizierungsergebnisse der deep learning Algorithmen auf Aufnahmen aus 45 cm Höhe (Zählrahmen) mit (A) hohem Anteil ALOMY und (B) geringem Anteil ALOMY (Wellhausen et al., 2020). VIAOR; Viola arvensis; VERSS, Veronica-Arten; TRZAW, Triticum aestivum; SOIL, Hintergrund; MATSS, Kamille-Arten; ALOMY, Alopecurus myosuroides.

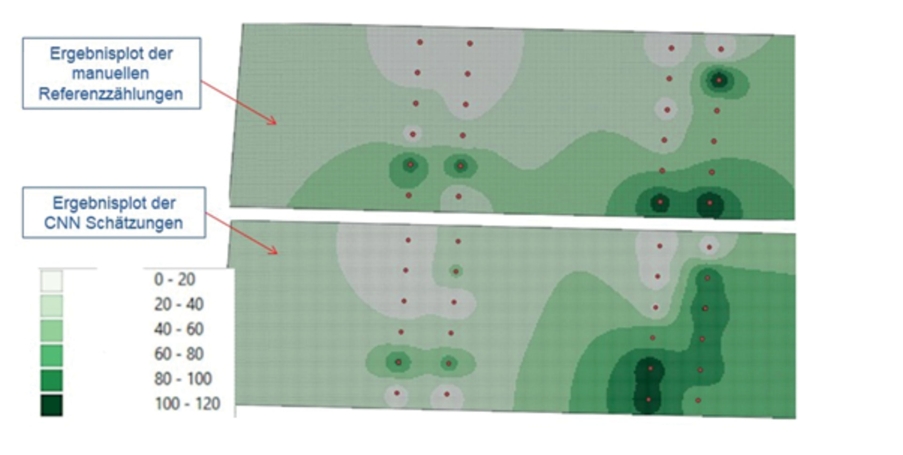

Um aus den Vorhersagekarten der Aufnahmen der einzelnen Boniturpunkte ganzflächige Unkrautverteilungskarten zu erstellen, ist neben der Interpolation zwischen den Punkten auch eine Umrechnung der vom Modell geschätzten Flächenanteile (Pixel) zu der Anzahl einzelner Unkrautpflanzen je m2 notwendig. Nur so lassen sich die Ergebnisse mit bestehenden Schadschwellenkonzepten bearbeiten. Da die hier verwendeten Bildaufnahmen zudem nur einen geringen Flächenausschnitt widerspiegeln, erfolgte als nächster Schritt eine Anwendung der deep-learning-Algorithmen auf den ebenfalls erstellten UAV-gestützten Luftbildaufnahmen (Abb. 9).

Abb. 9. Exemplarischer Vergleich von Verteilungskarten (MATSS und VIOAR) bei manueller Bonitur und Luftbildauswertung (Wellhausen et al., 2020).

Aus den Daten geht hervor, dass die automatische Luftbildauswertung in weiten Teilen ähnliche Ergebnisse lieferte wie die manuelle Bonitur. Eine Verbesserung des Systems kann also dazu beitragen, die Erhebung von Unkrautdichten auf der Ackerfläche erheblich zu beschleunigen.

Die in diesem Teilprojekt generierten Ergebnisse wurden vom JKI-Institut für Anwendungstechnik im Pflanzenschutz und dem Partner GID (GeoInformationsdienst GmbH) weiterverarbeitet und in das Assistenzsystem eingebunden.

Der hier gewählte Ansatz ermöglicht grundsätzlich die Unterscheidung von Unkrautarten auf Ackerflächen. Um eine praxisrelevante Unkrauterkennung umzusetzen, muss der Ansatz mithilfe von weiteren Luftbildaufnahmen unter Feldbedingungen evaluiert werden, damit die natürliche Variabilität auf ackerbaulich genutzten Flächen besser abgebildet werden kann. Flugroboter werden in der Landwirtschaft bereits vielfältig eingesetzt. Auch für das Unkrautmanagement stellen sie eine heute interessante Alternative zu bisherigen Erfassungsmethoden dar. Für den Praxiseinsatz sind jedoch insbesondere bei der Flächenleistung und der automatischen Bilderkennung noch weitere Verbesserungen notwendig.

Weitere Schritte werden die Validierung der BoVW-Modelle auf im Feld gesammelte Bildern beinhalten. Mit Daten von verschiedenen Feldern und damit verschiedenen Unkrautarten kann der Kalibrierungsdatensatz erweitert werden, so dass eine größere Anzahl von Unkrautarten erkannt wird. Die klassifizierten Bilder werden anschließend zur Erstellung von Unkrautverteilungskarten verwendet.

Künstliche Neuronale Netze und KI werden sich in den kommenden Jahren weiterentwickeln, weshalb davon ausgegangen werden kann, dass sich das Fachgebiet Bild- und speziell Unkrauterkennung schnell weiterentwickeln wird. Dafür spricht ebenfalls, dass zunehmend Bilddatensätze veröffentlicht werden, die es in ihrer Gesamtheit erlauben größere Trainingsdatensätze zu nutzen und eigene Datensätze zu verfeinern. Dies wird mittelfristig zu einer weiteren Leistungssteigerung in der Unkrauterkennung führen.

Die Förderung des Vorhabens erfolgt (bzw. erfolgte) aus Mitteln des Bundesministeriums für Ernährung und Landwirtschaft (BMEL) aufgrund eines Beschlusses des Deutschen Bundestages. Die Projektträgerschaft erfolgt (bzw. erfolgte) über die Bundesanstalt für Landwirtschaft und Ernährung (BLE) im Rahmen des Programms zur Innovationsförderung.

Die Autoren erklären, dass keine Interessenskonflikte vorliegen.

Chollet, F., 2015: keras. Zugriff: 7. Januar 2021, URL: https://github.com/fchollet/keras.

Christensen, S., T. Heisel, A.M. Walter, E. Graglia, 2003: A decision algorithm for patch spraying. Weed Research 43 (4), 276–284, DOI: 10.1046/j.1365-3180.2003.00344.x.

Dobers, E.S., 2002: Methoden der Standorterkundung als Grundlage des DGPS-gestützten Ackerbaus eine Fallstudie aus dem Lössgebiet des Mittleren Fläming. Dissertation, Universität Göttingen - Inst. für Bodenwiss.

Dyrmann, M., H. Karstoft, H.S. Midtiby, 2016: Plant species classification using deep convolutional neural network. Biosystems Engineering 151, 72-80.

Häusler, A., H. Nordmeyer, 1999: Characterizing spatial and temporal dynamics of weed seedling populations. Precision agriculture '99, Part 1 and Part 2. Papers presented at the 2nd European Conference on Precision Agriculture, Odense, Denmark, 11-15 July 1999, 463-472.

Kluge, A., H. Nordmeyer, 2012: Verfahren der Bildanalyse zur Unkrauterkennung in Getreide: Procedures of image analysis for weed recognition in cereals. Julius-Kühn-Archiv (434), 235–242, DOI: 10.5073/jka.2012.434.000.

Krizhevsky, A., I. Sutskever, G.E. Hinton, 2017: ImageNet classification with deep convolutional neural networks. Communications of the ACM 60 (6), 84–90, DOI: 10.1145/3065386.

López-Granados, F., 2011: Weed detection for site-specific weed management: mapping and real-time approaches. Weed Research 51 (1), 1-11.

Milberg, P., E. Hallgren, 2004: Yield loss due to weeds in cereals and its large-scale variability in Sweden. Field Crops Research 86 (2-3), 199–209, DOI: 10.1016/j.fcr.2003.08.006.

Nordmeyer, H., 2006: Patchy weed distribution and site-specific weed control in winter cereals. Precision Agriculture 7 (3), 219–231, DOI: 10.1007/s11119-006-9015-8.

Pflanz, M., H. Nordmeyer, 2016: Automatisierte Unkrauterkennung auf dem Acker – Möglichkeiten und Grenzen. Julius-Kühn-Archiv (452), 241, DOI: 10.5073/jka.2016.452.033.

Pflanz, M., H. Nordmeyer, M. Schirrmann, 2018a: Weed Mapping with UAS Imagery and a Bag of Visual Words Based Image Classifier. Remote Sensing 10 (10), 1530, DOI: 10.3390/rs10101530.

Pflanz, M., M. Schirrmann, H. Nordmeyer, 2018b: Räumlich hochauflösende Unkrauterkennung mittels Flugroboter und merkmalsextrahierender Bildverarbeitung. Julius-Kühn-Archiv 458, 379–384, DOI: 10.5073/JKA.2018.458.056.

Pohl, J.P., D. von Hörsten, J.K. Wegener, B. Golla, I. Karpinski, S. Rajmis, C. Sinn, H. Nordmeyer, C. Wellhausen, B. Kleinhenz, M. Herrmann, H. Dunekacke, A. Matthiesen, F. von Bargen, D. Jahncke, D. Feise, M. Röhrig, R. Sander, 2020: Assistance system for the site-specific use of herbicides. Julius-Kühn-Archiv (464), 216–221, DOI: 10.5073/jka.2020.464.033.

Wellhausen, C., M. Pflanz, J.-P. Pohl, H. Nordmeyer, 2019: Automatic weed recognition for site-specific herbicide application. The 12th European Conference on Precision Agriculture: 8-11 July 2019, Montpellier, France; Book of abstracts of all the Posters, 196-197.

Wellhausen, C., M. Pflanz, J.-P. Pohl, H. Nordmeyer, 2020: Generierung von Unkrautverteilungskarten auf der Basis automatischer Annotierungen in Feldaufnahmen. Julius-Kühn-Archiv (464), 222, DOI: 10.5073/jka.2020.464.034.